Tácticas y herramientas probadas para optimizar los costes de Kubernetes

Kubernetes se ha convertido en la plataforma de referencia para la orquestación de contenedores, facilitando a las organizaciones el despliegue, escalado y gestión de aplicaciones en contenedores en la nube. Pero esta potencia conlleva complejidad y, a menudo, costes sorpresa derivados de nodos infrautilizados, una mala autoescalabilidad vertical de los pods, una configuración ineficiente de solicitudes/límites, o cargas de trabajo ociosas de larga duración. La observabilidad de los costes de Kubernetes está fragmentada, y esa visibilidad de los costes a menudo no se admite de forma nativa entre clústeres o espacios de nombres sin herramientas adicionales.

Las organizaciones pueden encontrarse con que sus gastos en Kubernetes se disparan sin una estrategia clara de optimización. Los elevados costes de Kubernetes suelen derivarse de problemas arquitectónicos y operativos específicos. Entre ellos se incluyen los grupos de nodos sobreaprovisionados que superan las demandas reales de carga de trabajo, el empaquetamiento ineficiente de pods en nodos que deja sin utilizar una valiosa capacidad informática, y la falta de mecanismos de autoescalado (como el Autoescalado Horizontal de Pods, el Autoescalado Vertical de Pods o el Autoescalado de Clústeres) que ajustarían dinámicamente los recursos en función del uso.

Por eso, ser proactivo y echar un vistazo a tu gasto en Kubernetes puede ayudarte a controlar los costes y maximizar tu ROI. Este artículo examina consejos prácticos y herramientas para ayudar a los equipos a hacerse cargo de las cargas de trabajo y los gastos de Kubernetes, manteniendo al mismo tiempo el buen funcionamiento de sus operaciones.

¿Qué factores hacen necesaria la optimización de costes de Kubernetes?

Los entornos Kubernetes pueden convertirse en importantes centros de costes sin una gestión adecuada. Varios factores contribuyen a estos gastos:

Ineficacia de los recursos informáticos suele encabezar la lista de preocupaciones por los costes. Sin un dimensionamiento adecuado, muchas organizaciones sobreaprovisionan recursos de CPU y memoria para evitar problemas de rendimiento, lo que da lugar a bajas tasas de utilización y al desperdicio de recursos en la nube. De hecho, los estudios demuestran que El 65% de las cargas de trabajo Kubernetes utilizan menos de la mitad de su CPU y memoria solicitadas. Esto ocurre principalmente porque se sobreaprovisionan las solicitudes de recursos en relación con los límites y el uso real. Los programadores de Kubernetes se basan en las solicitudes de recursos -no en el uso real- para tomar decisiones sobre la ubicación de los nodos. Cuando se inflan estas solicitudes, se produce un mal empaquetamiento de los contenedores y un recuento de nodos innecesariamente alto, ya que los contenedores reciben más recursos de los que realmente necesitan para evitar problemas de capacidad.

Costes de almacenamiento pueden acumularse rápidamente en entornos de nube Kubernetes. Los volúmenes persistentes, especialmente aquellos con clases de almacenamiento premium, pueden suponer un coste significativo que aumenta a medida que crecen los datos de tu aplicación. Otros factores que contribuyen a ello son los PVCs retenidos tras la eliminación del pod y las políticas de retención excesiva de instantáneas o copias de seguridad. Las aplicaciones heredadas migradas a Kubernetes pueden conllevar patrones de almacenamiento ineficientes que aumentan aún más los costes. Optimizar el almacenamiento suele requerir la coordinación entre los equipos de infraestructura y de aplicaciones, especialmente para las cargas de trabajo con estado, en las que las decisiones de gestión de datos afectan directamente tanto al rendimiento como al gasto.

Gastos de red son otro factor de coste, sobre todo en despliegues multirregionales o híbridos. La transferencia de datos entre zonas, regiones y servicios externos puede acarrear gastos significativos que muchos equipos pasan por alto durante la planificación inicial de la arquitectura.

Recursos ociosos son también una importante fuente de despilfarro en los entornos Kubernetes. Los clústeres de desarrollo y pruebas que se ejecutan fuera de horario, los volúmenes persistentes sobrantes y los equilibradores de carga no utilizados pueden contribuir a generar costes innecesarios. Sin una gobernanza adecuada, estos recursos ociosos pueden acumularse, aumentando tus costes totales de Kubernetes.

Estrategias clave para reducir tus costes de Kubernetes

Entender cómo se combinan estos factores es clave para crear una arquitectura de arquitectura Kubernetes y gestionar la eficiencia de los costes. He aquí algunas estrategias que puedes aplicar para reducir tus costes de Kubernetes.

1. Dimensiona los recursos de los nodos

Redimensionamiento es quizás la estrategia más impactante para reducir los gastos de Kubernetes, y entender por qué requiere comprender un concepto fundamental sobre los costes de Kubernetes. Todo lo demás consiste en maximizar la eficiencia de esa infraestructura de pago.

Rightsize nodes se centra en ajustar los recursos a las necesidades reales de la aplicación, en lugar de limitarse a las estimaciones o a los ajustes por defecto. Así te aseguras de obtener el máximo valor de cada nodo por el que pagas.

Empieza analizando los patrones históricos de utilización de recursos en tus clusters. Identifica los pods que utilizan sistemáticamente mucha menos CPU o memoria de la solicitada. Muchas organizaciones descubren que pueden reducir las solicitudes de recursos sin afectar al rendimiento de las aplicaciones, lo que les permite empaquetar más cargas de trabajo en los nodos existentes.

Establece cuotas de recursos a nivel de espacio de nombres para evitar el uso excesivo, y da a los equipos límites claros dentro de los cuales trabajar. Estas cuotas ayudan a hacer cumplir las políticas organizativas y evitan picos de costes inesperados por cargas de trabajo desbocadas que podrían forzar un escalado innecesario de nodos.

Haz cumplir las políticas de solicitudes de recursos frente a límites. Implementa herramientas de aplicación de políticas como Gatekeeper para asegurarte de que cada carga de trabajo especifica tanto las solicitudes de recursos como los límites. Las solicitudes de recursos determinan cómo Kubernetes programa los pods en los nodos (lo que afecta a tus costes de computación), mientras que los límites evitan que los contenedores individuales consuman recursos excesivos que podrían afectar a otras cargas de trabajo. Sin las solicitudes adecuadas, Kubernetes no puede empaquetar eficazmente las cargas de trabajo, lo que conduce a la infrautilización de nodos y al despilfarro de recursos.

Considera la posibilidad de utilizar autoescalado vertical (VPA) en modo recomendación inicialmente. Esto proporciona información sobre las solicitudes de recursos adecuadas en función de los patrones de uso reales antes de aplicar los ajustes automáticos. Combinado con el autoescalado horizontal de pods (HPA), el autoescalado vertical de pods crea una estrategia de escalado más completa que optimiza la utilización de los recursos a la vez que maneja eficientemente las cargas de trabajo variables. Sin embargo, ten en cuenta que VPA y HPA pueden entrar en conflicto cuando ambos se dirigen simultáneamente a las métricas de CPU/memoria, lo que requiere un ajuste cuidadoso para evitar conflictos de escalado. En última instancia, esta práctica te ayuda a extraer el máximo valor de cada nodo por el que estás pagando.

2. Utilizar instancias puntuales

Instancias puntuales (o máquinas virtuales preferentes en Google Cloud) ofrecen importantes descuentos en comparación con las instancias bajo demanda estándar. Estas instancias aprovechan la capacidad no utilizada en los centros de datos de los proveedores de la nube, pero pueden recuperarse con un preaviso mínimo.

Kubernetes proporciona capacidades fundamentales para las terminaciones de instancias puntuales cuando se combina con lógica o herramientas personalizadas. Configurando los presupuestos de interrupción de pods, implementando reglas apropiadas de taints/tolerancias y afinidad de nodos, y asegurándote de que las aplicaciones están diseñadas para ser resistentes, puedes ejecutar con seguridad muchas cargas de trabajo en instancias puntuales sin comprometer la fiabilidad.

Céntrate primero en cargas de trabajo sin estado y tolerantes a fallos, como trabajos de procesamiento por lotes o aplicaciones escalables horizontalmente. Para entornos de producción, un enfoque híbrido que combine instancias puntuales con nodos bajo demanda proporciona tanto ahorro de costes como estabilidad.

3. Despliega una gobernanza automatizada

Gobernanza automatizada proporciona un control continuo de los costes mediante la aplicación de políticas como código y controles en tiempo de ejecución a lo largo del ciclo de vida de Kubernetes. Implementa políticas dirigidas a las fuentes habituales de despilfarro:

- Exige límites de recursos y solicitudes para todas las implantaciones.

- Imponer el uso adecuado de la clase de almacenamiento en función de los requisitos de la carga de trabajo.

- Ordena etiquetas para la asignación de costes y el seguimiento de recursos.

- Apaga o reduce automáticamente los entornos de desarrollo fuera del horario laboral.

Herramientas como CloudFlow de DoiT pueden aplicar estas políticas directamente en tu entorno Kubernetes, evitando que se creen recursos que no cumplan la normativa y manteniendo la disciplina de costes en todos los equipos.

4. Utiliza la supervisión granular

Una optimización eficaz de los costes requiere visibilidad de los patrones de consumo de recursos, que puede conseguirse mediante soluciones de supervisión de costes que proporcionen:

- Métricas de utilización de recursos a nivel de pod

- Estadísticas de eficiencia de los nodos

- Asignación de costes basada en espacios de nombres y etiquetas

- Tendencias históricas y detección de anomalías

Esta supervisión granular te permite identificar oportunidades de optimización y atribuir costes a equipos, proyectos o aplicaciones específicos. Sin embargo, muchos entornos Kubernetes luchan con un etiquetado incompleto o incoherente, lo que limita la precisión en la asignación de costes. Además, las herramientas nativas de facturación en la nube a menudo carecen de granularidad específica para Kubernetes. Con una visibilidad clara de los patrones de consumo, puedes tomar mejores decisiones basadas en datos sobre la asignación de recursos y el escalado de clústeres.

Las soluciones de monitorización más eficaces se integran con tu pila de observabilidad existente, al tiempo que aprovechan los conocimientos especializados sobre los costes de Kubernetes.

5. Aplicar técnicas de escalado pod

El escalado estratégico de los pods complementa el dimensionamiento de los recursos para una optimización integral de los costes. Considera la posibilidad de implementar el autoescalado horizontal de pods basado en métricas personalizadas relevantes para tus aplicaciones específicas, aunque recuerda que no todas las cargas de trabajo se benefician del HPA. Por ejemplo, las aplicaciones con estado o aquellas con tiempos de arranque prolongados pueden requerir enfoques diferentes. El escalado basado en la longitud de la cola o en la latencia de la solicitud suele proporcionar una mejor alineación con los requisitos empresariales que la utilización de la CPU por sí sola.

Configura cuidadosamente el autoescalado del clúster, teniendo en cuenta restricciones como el tiempo de calentamiento de los nodos y las comprobaciones de dependencia. Esto garantiza que los nodos se añaden o eliminan adecuadamente a medida que cambian las necesidades de los pods, evitando tanto el desperdicio de recursos como la escasez de capacidad.

Para aplicaciones con patrones de uso predecibles, implanta un escalado programado para ajustar los recursos de forma preventiva antes de que cambie la demanda, sobre todo para aplicaciones con patrones claros de horas de trabajo o requisitos de procesamiento periódico conocidos.

Por qué es importante optimizar los costes de Kubernetes

Más allá de los beneficios económicos obvios, la optimización de costes de Kubernetes ofrece varias ventajas estratégicas. La utilización eficiente de los recursos mejora el rendimiento de las aplicaciones al reducir la contención y proporcionar un escalado más predecible. Además mejora la sostenibilidad medioambiental mediante un menor consumo de energía, una consideración cada vez más importante para las organizaciones socialmente responsables.

La mitigación del riesgo es otra ventaja crítica que a menudo se pasa por alto. Una optimización adecuada de los costes reduce significativamente la exposición al riesgo de rebasamiento de cuotas e inanición de recursos, preocupaciones reales en entornos multi-arrendatario o críticos para el negocio. Cuando los recursos tienen un tamaño adecuado y se asignan correctamente, las organizaciones evitan situaciones en las que las cargas de trabajo ineficientes de un equipo consumen una capacidad de clúster excesiva. Esto ayuda a evitar problemas como el estrangulamiento de la CPU, los OOMKills o los pods no programables que resultan del agotamiento de los recursos y privan a otras aplicaciones críticas de los recursos necesarios. Esta reducción del riesgo es especialmente importante en entornos compartidos, donde la disponibilidad de las aplicaciones afecta directamente a las operaciones empresariales.

Los entornos Kubernetes bien optimizados también demuestran ciclos de despliegue más rápidos. Cuando los equipos comprenden con precisión sus necesidades de recursos, pueden diseñar pipelines CI/CD más eficientes y agilizar los procesos de aprobación. Esta aceleración favorece la agilidad empresarial y una comercialización más rápida de las nuevas funciones.

Y lo que es más importante, mantener los costes de Kubernetes bajo control permite realizar previsiones más precisas. En estos casos, los equipos financieros ganan confianza en las previsiones presupuestarias de la nube mediante modelos de economía unitaria y de devolución/reembolso predecibles, ambos temas centrales de FinOps. Al mismo tiempo, los equipos de ingeniería ganan libertad para innovar sin provocar gastos inesperados.

Obstáculos potenciales para reducir tus costes de K8s

A pesar de los claros beneficios, las organizaciones pueden encontrarse con varios retos comunes a la hora de optimizar los costes de Kubernetes. La complejidad técnica puede ser un obstáculo importante, ya que la optimización de costes requiere conocimientos especializados sobre el comportamiento de la programación de vainas, los mecanismos de autoescalado y la observabilidad de los costes. Se trata de conocimientos que van más allá de la conocimientos de DevOps de los que carecen muchos equipos.

La coordinación entre equipos también puede ser difícil. Una optimización eficaz de los costes requiere la colaboración entre los equipos de finanzas, ingeniería y operaciones, que tradicionalmente funcionan en silos con diferentes prioridades y métricas de éxito.

Puede surgir resistencia al cambio, sobre todo en organizaciones en las que los equipos temen que la optimización provoque una degradación del rendimiento. Superar esta resistencia requiere educación sobre la relación entre la asignación adecuada de recursos y la mejora de la fiabilidad de las aplicaciones.

Uno de los principales retos de Kubernetes es la visibilidad de los costes, ya que no dispone de funciones integradas para realizar un seguimiento de los costes desde el principio. Muchas organizaciones despliegan Kubernetes sin darse cuenta de que la visibilidad de costes requiere unir métricas, etiquetas y datos de facturación de la nube, algo que la mayoría de los equipos pasan por alto durante el despliegue inicial. Si los equipos no pueden ver el impacto en los costes de sus decisiones en tiempo real, la optimización se convierte en reactiva en lugar de proactiva. Haciendo que el seguimiento de los costes forme parte de la incorporación e integrando las métricas de costes en los flujos de trabajo diarios, los equipos pueden tomar decisiones conscientes de los costes desde el primer día.

Por último, muchas organizaciones luchan con la sostenibilidad de la optimización. Las iniciativas puntuales de reducción de costes pueden suponer un ahorro inicial, pero sin procesos continuos y responsabilidad, los costes tienden a aumentar de nuevo con el tiempo.

Herramientas para la optimización y monitorización de costes de Kubernetes

Conseguir una optimización eficaz de los costes de Kubernetes requiere aprovechar las herramientas adecuadas para supervisar, analizar y gestionar el uso de los recursos de forma eficiente. Aquí tienes algunas herramientas populares de optimización de costes que pueden ayudarte con la optimización de costes de Kubernetes:

1. DoiT

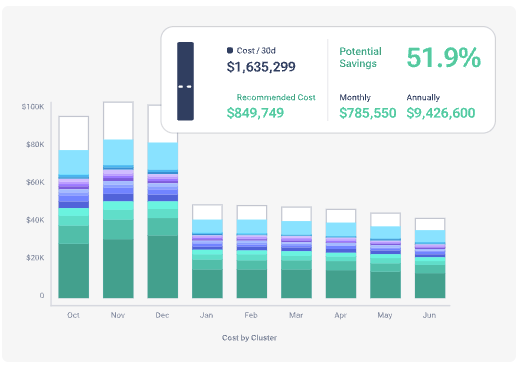

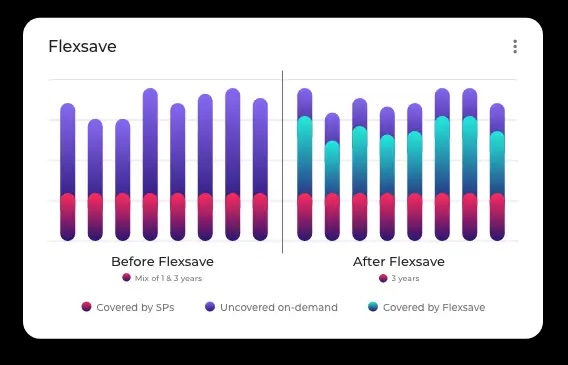

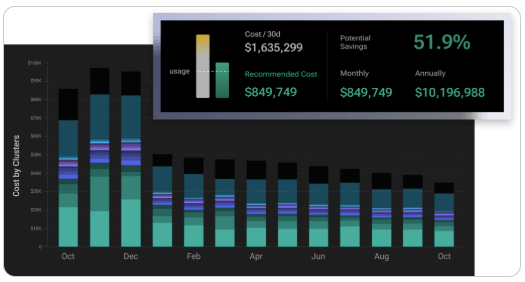

DoiT ofrece optimización de costes especializada en Kubernetes a través de su plataforma integral. Flexsave para Kubernetes proporciona un rightsizing inteligente y una optimización automática que reduce los costes manteniendo el rendimiento y la disponibilidad.

La plataforma utiliza inteligencia basada en datos para analizar los patrones de consumo y proporcionar recomendaciones procesables específicas para tus cargas de trabajo. A diferencia de las herramientas generales de gestión de costes en la nube, la solución de DoiT comprende las oportunidades de optimización específicas de Kubernetes y automatiza muchas tareas comunes.

Las organizaciones que implementan la optimización de costes de Kubernetes de DoiT han logrado importantes reducciones de costes, al tiempo que han mejorado el rendimiento general del clúster. Trax, por ejemplo, ahorró un 75% en su gasto en Kubernetes con PerfectScale de DoiT. La plataforma también proporciona una visualización avanzada y perspectivas que ayudan a correlacionar el gasto en Kubernetes con los objetivos empresariales, salvando las distancias entre los equipos financieros y de ingeniería.

2. Explorador de costes de AWS

Para organizaciones que ejecutan Kubernetes en AWS (incluido EKS), Explorador de costes de AWS proporciona visibilidad del gasto relacionado con los contenedores. El servicio te permite desglosar los costes por clúster, grupo de nodos y otras dimensiones cuando se aplica el etiquetado adecuado.

Aunque no está diseñado específicamente para Kubernetes, el Explorador de Costes ayuda a identificar tendencias y anomalías en tu gasto de EKS. Combinado con AWS Compute Optimizer, puede ser beneficioso para recomendar oportunidades de redimensionamiento de las instancias EC2 que sirven como nodos Kubernetes.

3. Azure Gestión de Costes + Facturación

Gestión de costes Azure ofrece capacidades similares para los clústeres AKS, proporcionando de nuevo algunas perspectivas, pero no recomendaciones. El servicio proporciona vistas de asignación de costes y seguimiento de presupuestos específicos de los recursos Kubernetes cuando se configura con las etiquetas y la agrupación de recursos adecuadas.

Las recientes mejoras de Azure han mejorado la información específica de los contenedores, incluyendo recomendaciones para el dimensionamiento de grupos de nodos y alertas de utilización para clústeres AKS. Estas funciones ayudan a las organizaciones a identificar oportunidades de optimización en sus entornos Kubernetes.

4. Medición del uso de GKE

Google Cloud ofrece visibilidad de costes especializada para GKE a través de su función de medición del uso. Esta capacidad proporciona métricas de atribución de costes y utilización de recursos a nivel de espacio de nombres, lo que permite un análisis más granular que los informes de facturación estándar de GCP.

Cuando se combina con el sistema de recomendación de Google Cloud, GKE Usage Metering ayuda a identificar oportunidades específicas de optimización en tus entornos Kubernetes basándose en patrones de uso históricos.

Próximos pasos para un gasto sostenible en Kubernetes

Implantar una optimización sostenible de los costes requiere un enfoque estructurado. Empieza por establecer una línea de base de tu gasto actual en Kubernetes, desglosado por clúster, espacio de nombres y aplicación. Esta línea de base proporciona un punto de referencia para medir el progreso de la optimización.

Céntrate primero en los esfuerzos de optimización que ofrezcan el mayor impacto y sean más fáciles de aplicar. Las victorias rápidas, como limpiar los recursos ociosos y aplicar políticas básicas de gobernanza, dan impulso a iniciativas más sustanciales.

Desarrollar un equipo interfuncional de optimización de costes con representantes de finanzas, ingeniería y operaciones. Este enfoque colaborativo garantiza que las decisiones técnicas se alineen con los objetivos financieros, manteniendo al mismo tiempo el rendimiento y la fiabilidad de las aplicaciones en tiempo real.

Por último, aplica ciclos de revisión periódicos para evaluar la optimización y afinar los progresos, al tiempo que identificas nuevas oportunidades. Poner esto en práctica no es un proyecto de un solo paso. Los entornos Kubernetes evolucionan continuamente, por lo que requieren una atención continua a la gestión de costes en lugar de esfuerzos de optimización puntuales.

Mediante el uso de estas tácticas probadas y el aprovechamiento de herramientas especializadas, tu organización puede lograr un importante ahorro de costes de Kubernetes, al tiempo que mejora la eficiencia operativa y mantiene el rendimiento y la escalabilidad de las aplicaciones.

¿Quieres saber más? Descárgate nuestro Guía FinOps sobre los costes y la complejidad de Kubernetes para saber cómo presupuestar estratégicamente para respaldar operaciones escalables en el ecosistema Kubernetes.